有时候需要仿站、离线下载到本地浏览、做镜像站之类的需求时需要下载整个网站,包括网站上面的图片 css js等,一个一个网页进行保存也不太可能,那就要用到整站下载工具了。设置好参数就可以自动进行离线下载到本地了,包括路径也会自动需改,非常方便。这里推荐两款国外网站离线下载器软件HTTrack Website Copier 和 Teleport Ultra,一款破解汉化 一款免费的,还有一个Linux的wget命令进行网站离线。

Teleport Ultra破解汉化版

Teleport ultra是Tennyson Maxwell公司研发的一款网站整站下载软件,它能够将整个网站的内容,包括图片、文字、视频等等内容都下载到你的电脑上,让用户即使在没有网络的状态下也能够完整的查看这个网站上的说有内容,且整个网站的链接、内容都是与在网页上一模一样的。

HTTrack Website Copier免费汉化版

HTTrack Website Copier是一个免费的离线浏览器工具,它能够让你从互联网上下载整个网站进行线下浏览。

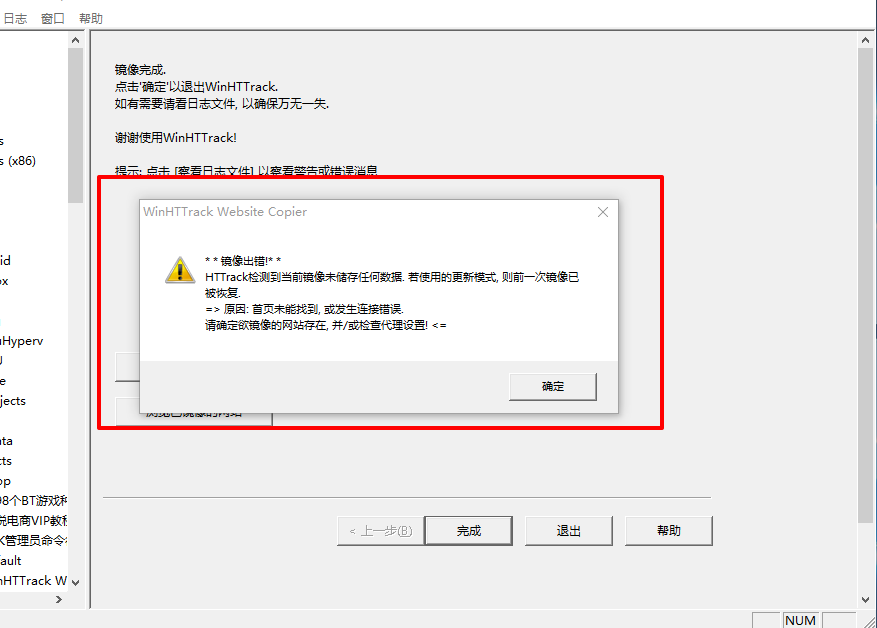

镜像出错怎么办

用HTTrack Website Copier离线下载一些网站的时候可能,由于网站robots.txt里面相关的反机器人设置,会导致镜像出错没法进行离线下载。错误日志里面的内容如下

警告:www.xxx.com/robots.txt永久移动

警告:重定向链接是相同的,因为“URL Hack”选项:www.xxx.com/robots.txt和https://www.xxx.com/robots.txt

警告:警告移动处理为www.xxx.com/robots.txt(真实的是https://www.xxx.com/robots.txt)

警告:www.xxx.com/永久迁移

警告:由于“URL Hack”选项:www.xxx.com/和https://www.xxx.com/,重定向链接是相同的

警告:文件已从www.xxx.com/移动到https://www.xxx.com/

警告:本次会议期间,似乎没有数据转移!:恢复前一个!

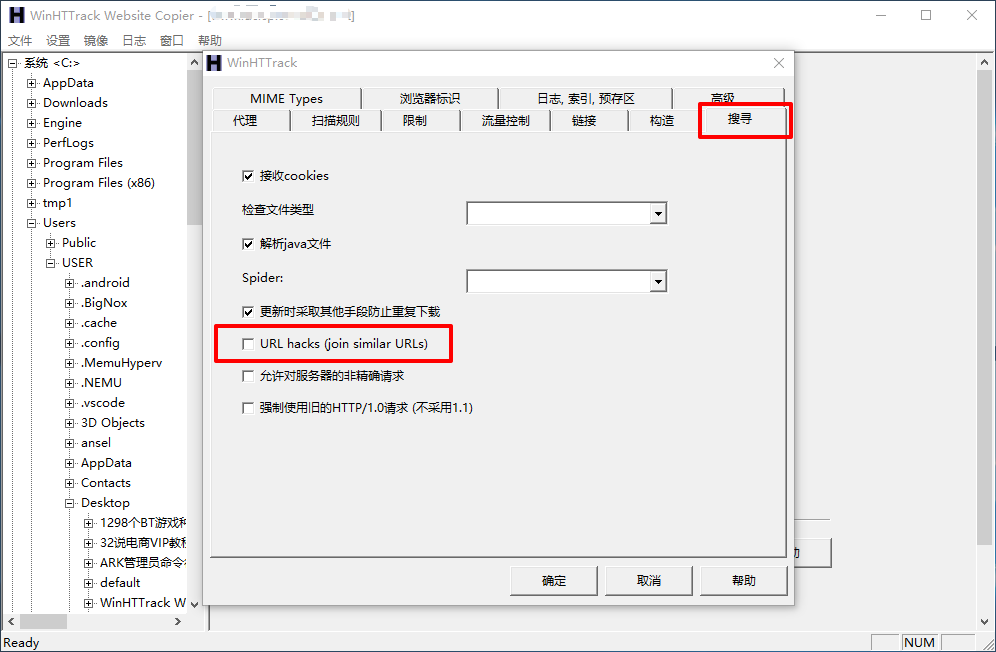

这种情况在新建工程,把选项设定里面的URL hacks取消勾选就可以解决。如下图设置

关于这个问题在官网论坛,老外也有讨论过,点这

还有一种情况

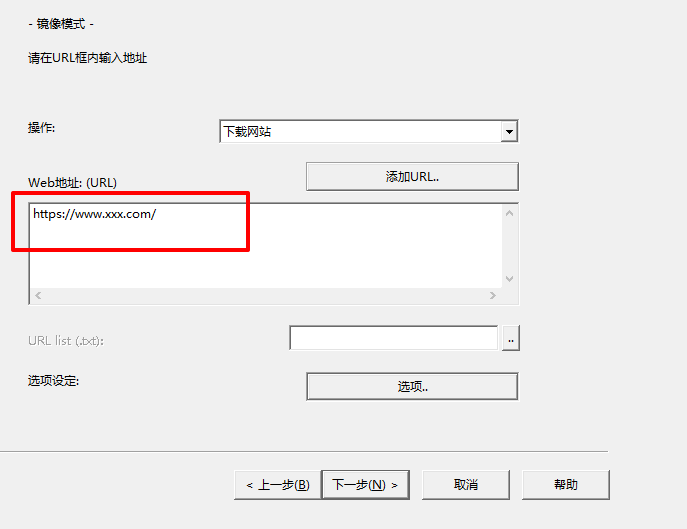

这种情况就是URL最后没有加 /,比如https://www.xxx.com/,最后一定要加上/,如下图

这个问题在这里也有答案

使用Linux的wget命令进行整站离线下载

- wget -U "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 5.1; GTB5)" -r -p -k -nc http://www.xxx.com

- -U 修改agent,伪装成firefox等浏览器,当某些网站拒绝下载的时候,加上这个参数就可以下载了。

- -p 下载页面显示所需的所有文件。## 下载指定目录

$ wget -c -r -nd -np -k -L -p -A c,h www.xxx.com/doc/path/ - -c 断点续传

- -r 递归下载,下载指定网页某一目录下(包括子目录)的所有文件

- -nd 递归下载时不创建一层一层的目录,把所有的文件下载到当前目录

- -np 递归下载时不搜索上层目录。

- -k 将绝对链接转为相对链接,下载整个站点后脱机浏览网页,最好加上这个参数

- -L 递归时不进入其它主机,如wget -c -r www.xxx.com/ 如果网站内有一个这样的链接: www.yyy.com,不加参数-L,就会像大火烧山一样,会递归下载www.yyy.com网站

- -p 下载网页所需的所有文件,如图片等

- -A 指定要下载的文件样式列表,多个样式用逗号分隔

更多的wget命令可以查看这个教程,《wget 使用探索》

下载整站下载器

两款软件可以搭配使用,如果用Teleport Ultra进行下载的网站有问题,可以换成HTTrack Website Copier再试试。

下载地址:Teleport Ultra v1.65 破解汉化版

下载地址:HTTrack Website Copier v3.49.2绿色汉化版

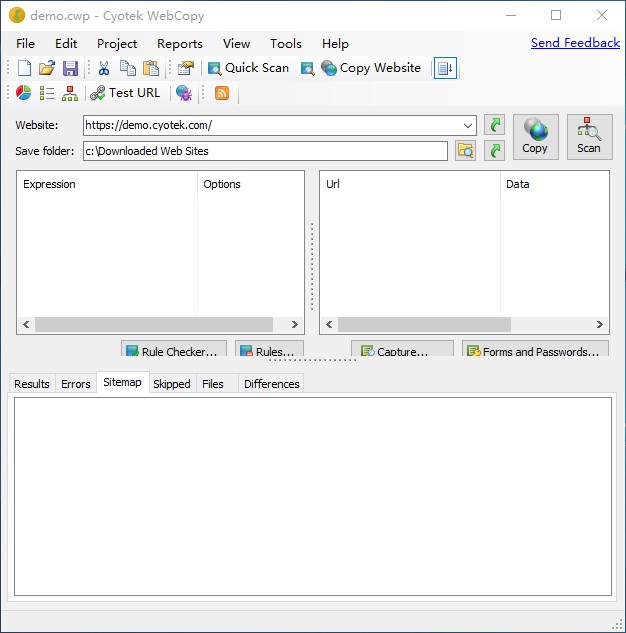

Cyotek WebCopy

Cyotek WebCopy是免费使用的,比上面推荐的两款软件功能都强。唯一遗憾就是没有汉化版,在网上也没有找到相关的中文信息介绍在国内比较冷门!使用上比较简单很好操作,想体验更多复杂的功能就得仔细研究了

简单使用教程:在Website输入网址,Save folder为保存地址,然后按F5开始复制

非特殊说明,本博所有文章均为博主原创。

如若转载,请注明出处:http://dcoet.com/wordpress/1636.html

共有 0 条评论